Alltså, jag är ibland skeptisk till hela den här grejen med estimat och har haft god erfarenhet av att bara lägga så litet tid på det som möjligt men ibland behövs det.

Om ni upplever att ni ofta missar med de estimat ni gör och att det orsakar problem för er så kan det här verktyget vara något att prova som jag hittade när jag läste “How to measure anything” Douglas Hubbard

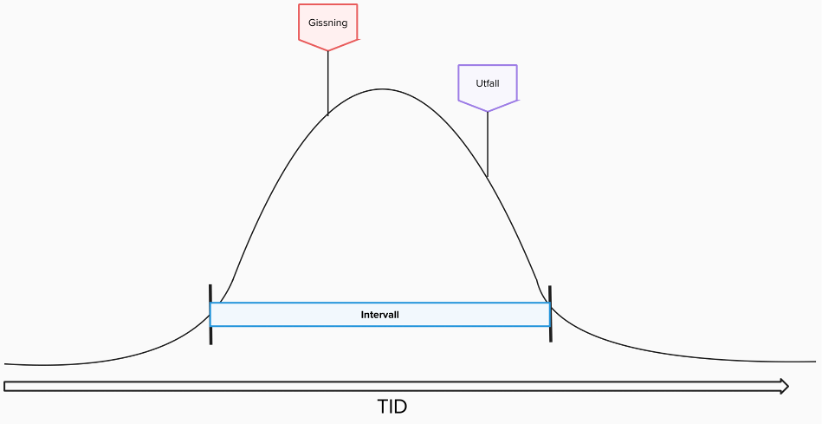

Idén är enkel – istället för att göra estimat som en siffra (t ex. 160h) så funderar ni i vilket intervall tiden för arbetet kan ligga mellan (T ex. 150h-200h)

”Men” säger du, ”då kommer alla bara säga att det är mellan noll och en miljon varje gång så blir det alltid rätt” och det har du alldeles rätt i. Om du ska pricka rätt alla gånger måste du gissa på helt löjligt stora intervall. Så vad göra?

Jo!

Du ber den som giss… estimerar att göra intervallet så stort att det är 90% chans att bli rätt. Det betyder att om ni gör 10 estimat så ska 9 vara rätt och ett bli fel.

Ni har då täckt upp för att det kan hända en del konstigheter men tagit bort extrema händelser.

Vet ni vad ni har fått som bonus? Jo, ni ser hur osäkra ni är på utfallet. Dvs om ett intervall är väldigt stort (säg 100-600h) då vet ni att någonting är väldigt osäkert här.

Och vad kan ni göra då? Jo, ni kan antingen välja mellan att satsa på risken eller att inte göra det och gå på ett säkrare alternativ.

-eller-

Så kan ni ägna litet tid åt att utforska det osäkra området för att få ett bättre estimat. Kanske visar det sig när ni petat litet på problemet att det inte var så konstigt och estimatet ramlar ner till 100-150h

Är du intresserad av detta går att plöja djupare och titta på Monte Carlo-simuleringar osv. Säg till i så fall